Quand la fin de vie devient une interrogation sociétale, il peut en être de même de la vie finie. Quand la première n’est pas exclusivement autocentrée, la seconde l’est totalement. Se préparer au départ ne prépare pas celui qui reste et l’expression « faire son deuil » a une réalité, car l’absence a sa consistance et c’est elle qui se fait entendre. À ce que l’on peut qualifier de trouble psychiatrique par sa durée, et la souffrance qui s’y associe, il existe pourtant une base anatomique constituée de circuits neuronaux dont le fonctionnement est altéré (A neurobiological perspective on prolonged grief disorder). Les zones impliquées appartiennent au système de récompense, celle-ci étant assimilée dans ce cas particulier « au fort désir de retrouver le défunt « . Ces résultats ne seraient que préliminaires, l’échantillonnage étant peu représentatif de part sa taille. Il n’en reste pas moins vrai que la douleur est réelle et qu’une solution pourrait se profiler à l’horizon (AI griefbots could change how we mourn — but there are serious risks ahead), mais avec la question suivante : « la fin justifie-t-elle les moyens » ? Car il ne s’agit ni plus ni moins que d’une résurrection numérique, encore que le vocable de « résurrection » convienne assez peu tant est grande la possibilité de faire de cet avatar une copie non conforme à la réalité. II serait en effet tentant de modifier dans un sens comme dans un autre, un parent pour expliciter le déroulé de sa vie : Folcoche contre Madame Rosa ! Quant aux motivations, si celles du demandeur sont dépourvues de toute finalité mercantile il n’en est pas de même concernant celles du concepteur de ce « bot de la mort » ! Ce qui interroge sur la démarche …

L’homme, le robot et la mort

février 28th, 2026Vous avez dit sérendipité, bizarre !

février 16th, 2026« Capacité, aptitude à faire par hasard une découverte inattendue et à en saisir l’utilité« . L’épistémologie regorge d’exemples en parfaite adéquation avec cette définition. Il peut s’agir d’une fulgurance qui s’impose, comme d’une constatation dont on saisit toute la portée. Sir A. Fleming et la pénicilline en sont l’Exemple le plus abondamment cité ; la question étant de savoir si cette « qualité indispensable » à l’avancée scientifique peu encore avoir cours (Can Science Still Afford Serendipity?). Poser cette question laisse entendre que la dite capacité peut ou non être, ce qui la rend contingente, d’où le fait qu’elle se situe dans une certaine plage d’indétermination ou de hasard. Le hasard fit que Sir Alexander Fleming était peu méticuleux et que dans son désordre une boite de Petri ensemencée se présenta différemment après avoir été et laissée sur la paillasse. Le hasard ne fait bien les choses que si l’homme sait exploiter ce qui sort de la routine. Mais pour ce faire il est indispensable de voir ce qui rompt avec l’usage mais aussi et surtout (?) comprendre que cette solution de continuité doit être explorer. La rupture épistémologique en à ce prix. Si la flexibilité du raisonnement est une condition sine qua non, il n’en reste pas moins vrai qu’elle demande un milieu favorable pour pouvoir s’y développer, d’où l’idée que la liberté est indispensable pour que toutes les explorations appartiennent à tous les possibles. Ainsi la rigueur ne doit pas être synonyme de rigidité, pas plus que la technicité synonyme de solitude.

Ancien adage et actualité !

février 14th, 2026Qui ne s’est pas entendu dire « Mens sana in corpore sano » par un collègue/ami bien intentionné et néanmoins perfide ? Le sous entendu étant évidemment lourd de sens parmi les quels, l’esprit est sain si le corps l’est également. Aujourd’hui celui à qui s’adressait le malicieux est non seulement parfaitement au courant mais encore acquiesce d’autant plus vigoureusement qu’il en connaît l’explication (Exercise rewires the brain for endurance). En effet si les athlètes savent depuis longtemps qu’il leur est indispensable de s’entrainer pour améliorer leurs performances, on sait aujourd’hui que l’exercice physique « pourrait aussi stimuler les neurones« , c’est ce qui a été constaté chez les souris, elles qui travaillent comme on le sait pour le bien de l’humanité ! L’examen des neurones producteurs de la protéine SF1 impliquée dans la physiologie de l’endurance, non seulement montre qu’ils sont plus facilement excitables mais encore qu’ils augmentent le nombre de leurs synapses, ce qui correspond à une augmentation de leurs sites de connexion. Cette étude histo-physiologique a été confirmée par une autre approche dite opto-génétique, reposant sur l’illumination cérébrale. Si l’on ajoute l’influence bénéfique du sommeil sur le cerveau, dont fait partie son nettoyage par des cellules destinées à cet effet (These hungry immune cells tidy sleeping flies’ brains, https://rdcu.be/e3Y6t et https://www.livescience.com/health/sleep/does-the-brain-flush-out-toxins-while-you-sleep) personne ne pourra plus dire « Ça sert à quoi ? »

LUCA

février 9th, 2026Ce n’est pas un prénom mal orthographié, c’est l’Ancêtre avec un grand A ! Celui sur leque les scientifiques fantasment, « le dernier ancêtre commun à toutes les espèces vivant actuellement sur terre« , il y a « environ » plus de quatre milliards d’années. A une telle échelle de temps, les preuves appartiennent au domaine de l’hypothétique ! Il ne s’agit pas de l’alpha de la vie sur terre, mais du dernier organisme, déjà complexe, à l’origine des domaines, deux ou trois, postulés de l’arbre phylogénétique. Mais La grande question reste le processus d’apparition de la vie, soit le passage du non vivant au vivant ce qui impose une définition, celle du vivant dont l’expression la plus simple pourrait être l’apparition de la reproduction. Mais dans ce processus, si la replication est indispensable elle ne peut être unique puisqu’elle doit s’accompagner de phénomènes de catalyse de telle sorte que l’ADN, pour la replication, ne peut en aucun cas être seul en cause. La grande découverte concerne l’ARN dont les chercheurs ont mis en évidence sa capacité de catalyse. Si l’accord s’est fait sur la préséance de l’ARN sur l’ADN, il n’en reste pas moins vrai que l’émergence de l’ARN appartient toujours au domaine de l’inconnu. (How RNA reveals clues to life’s origins on Earth). Comme aucun artefact n’est imaginable, les hypothèses sont de rigueur. Reste peut-être une « dernière voie » à explorer, néanmoins aussi escarpée que les précédentes, à savoir la recherche de traces primitives extra terrestres qui trouveraient leur place dans la chaîne évènementielle présupposée.

cc

Introspection

février 3rd, 2026Tout regard sur soi-même est une plongée dans UN intime en quête de ses motivations, mais en réalité une démarche peu sûre car celui qui s’y adonne en connaît mal les cheminements profonds et tout aussi mal le résultat de la dite démarche. Néanmoins, il est presque certain que seul l’homme en est capable, dans la mesure où peu nombreux sont les animaux qui se reconnaissent comme entité pensante. En fait la première question concerne le besoin qu’aurait l’IA d’avoir et d’accéder à SA conscience or la réponse concerne l’utilisateur de la dite IA et non pas l’IA en propre. C’est au vu et au su d’erreurs qui lui seraient imputables et dont pâtirait l’utilisateur que cette dernière aurait besoin de réfléchir sur elle-même. (Giving AI the ability to monitor its own thought process could help it think like humans) ? Mais pour y arriver il semble bien qu’il n’existe que des méthodes humaines pour y parvenir et dans ces conditions il ne reste plus qu’à insuffler à la machine les réseaux neuronaux pour y accéder. La machine n’y est pour rien, l’homme est toujours son souffle de vie même si la multiplication des réseaux lui permet d’apprendre et de donner des réponses dans un temps qui se rapproche de l’immédiateté et de la vérité si cette dernière est considérée comme en adéquation avec la réalité ! Un deuxième article (AI has already won the ‘imitation game’) vient compléter le précédent dans la mesure où il permet de verser au dossier des arguments à partir du test de Turing (1950). Ne reste plus qu’à définir l’intelligence humaine, ce qui constitue déjà un vaste projet, pour affirmer ou nier l’existence d’une réelle « intelligence » artificielle telle que définie par Turing. L’homme a peut-être dévoilé (Heidegger), un nouveau type d’intelligence tel que « Notre rôle dans le monde et notre compréhension de l’esprit en seront transformés« .

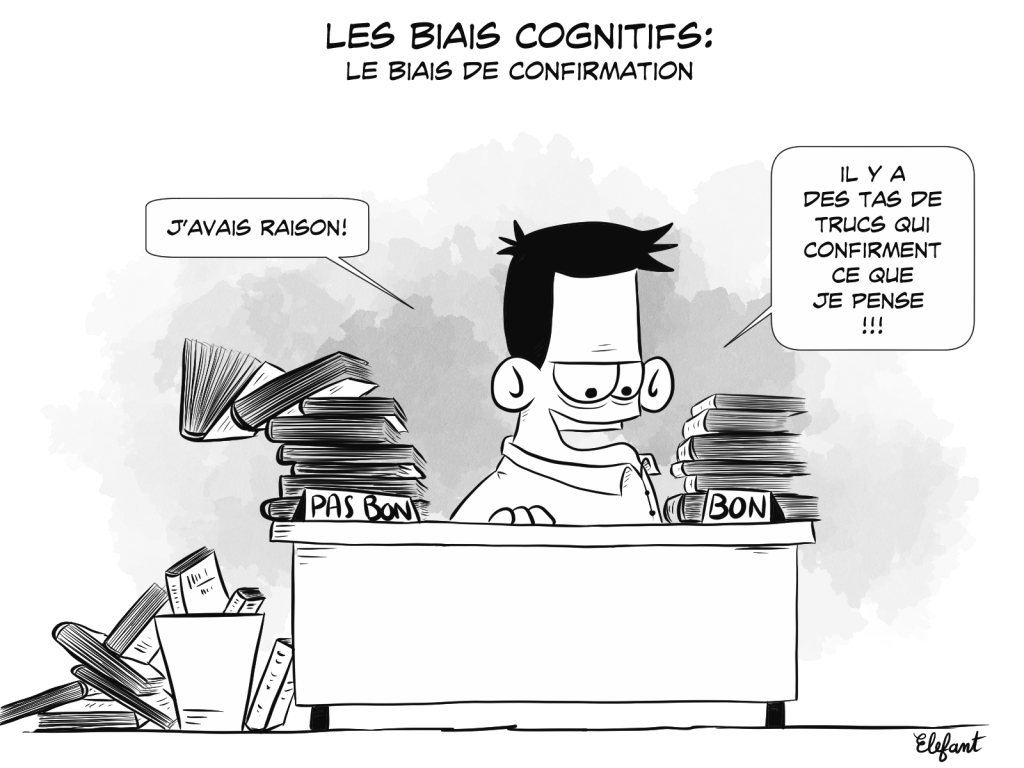

Vivifiant ou délétère ?

janvier 16th, 2026Le biais cognitif se caractérise par la propension qu’un sujet à de chercher, voir, retenir tout ce qui s’inscrit dans un schéma, son schéma, qui a quitté la réalité pour être perçu à sa façon. Si cette description semble un peu facile sinon simpliste elle traduit néanmoins une distorsion de la réalité, une atteinte de la rationalité de l’individu qui en fait montre. Or aujourd’hui les applications courantes des acquisitions scientifiques se sont accélérées à un point tel que leur perception s’apparente plus à de la magie inexplicable qu’à la normalité. C’est la raison pour laquelle après avoir loué « trop tôt » les services qu’allait rendre l’IA, il est devenu de bon ton de la vouer au gémonies, voire à imaginer de l’interdire sans autre forme de procès ! C’est pourquoi si l’on désire regarder en face ce nouveau produit démoniaque, on pourrait lire un article récent qui traite du sujet pour le démystifier : AI can spark creativity — if we ask it how, not what, to think. L’idée est simplissime et universelle : tout nouvel outil requiert un nouveau mode d’emploi qui lui soit spécifique, c’est à dire dont la finalité ne soit pas dévoyée. Le marteau a été créé pour taper sur un clou par sur la tête de son voisin ! Et donc savoir utiliser l’IA, c’est savoir lui poser les bonnes questions, pas lui demander de répondre à la place de celui qui l’a créée mais de lui fournir les éléments de réponse qui ne sont pas tous simultanément et dans l’instant en sa possession.

La chimère et l’éternité

janvier 4th, 2026Qu’elle fut fille d’Hésiode, d’Homère ou d’Apollodore, la chimère n’était pas un être attirant à l’exception peut-être de ses seuls parents. Terrible, elle meurt sous les coups de Bellérophon. Mais ce qui est rarement rapporté, c’est que de ses épousailles naissent le Sphynx et le lion de Némée, deux autres créatures tout aussi redoutables. Cette filiation n’est pas sans rapport avec ce qui va suivre (Some of your cells are not genetically yours — what can they tell us about life and death?).Les interprétations auxquelles cet être né de l’imaginaire des anciens ont donné lieu sont multiples, mais le terme lui-même de chimère a été repris par les » biologistes [qui] ont utilisé ce terme, il y a déjà plus de 100 ans, pour désigner les organismes constitués de plusieurs cellules ayant des origines génétiques différentes. Au début, on utilisait ce terme surtout en botanique. Mais on s’est rendu compte que les mammifères aussi étaient des chimères« . La révolution qu’apporte la connaissance que les êtres vivants sont tous des chimères invalide deux concepts universels. Le premier postule que les enfants descendent de leurs parents ; le microchimérisme démontre que le trajet inverse est possible puisque c’est l’ascendance maternelle (la mère) qui renferme des cellules provenant de son enfant ! Le second postule que le système immunologique repose sur le « soi » et la reconnaissance du « non soi » : les cellules microchimériques vont pouvoir ou non, car ce n’est pas inéluctable, provoquer une réponse de rejet. Ainsi la chimère peut-elle ou non être ce monstre des anciens. Mais dans un cas comme dans l’autre, c’est la mère et son embryon, les seuls acteurs mis en cause. L’ADN mitochondrial et le microchimérisme démontrent qu’il existe bien une empreinte féminine spécifique à l’origine d’un double cheminement temporel.

La querelle des anciens et des modernes

décembre 16th, 2025A la fin du XVIIème siècle naît au sein de l’Académie Française la querelle des Anciens et des Modernes. Les premiers menés par Boileau, soutiennent que la création littéraire doit mettre ses pas dans ceux de l’Antiquité, tandis que les Modernes à la suite de Perrault, tiennent le siècle de Louis XIV pour parfait et militent pour qu’il soit la référence en matière artistique. Au XXIème siècle, l’étude des vestiges des constructions de Pompéi donne à apprendre aux ingénieurs actuels. Les méthodes utilisées par les romains avaient déjà été relatées par Vitruve en son temps mais étaient restées manifestement inconnues des bâtisseurs ultérieurs. Contrairement au domaine militaire où les grands stratèges sont tout naturellement étudiés depuis que leurs campagnes ont été rapportées, il n’en n’est pas de même quand il s’agit de certains des acteurs de la société civile. Ainsi eut-il été intéressant et utile de se pencher sur les méthodes pratiquées par les romains dans leur fabrication du béton ! (Pompeii reno reveals Roman concrete secret). En effet, si les recettes s’en sont modifiées depuis le XVIIIème siècle, elles n’ont pas intégré une caractéristique spécifique du béton romain utilisé dés le IIIème siècle av. J-C. Sa longévité qui pourrait irriter les modernes tient en effet à sa capacité d’autoréparation ! Serait-ce à dire que certaines des facilités que génère le progrès cherchent plus à s’inscrire dans l’immédiateté que dans la durée, sans tenir précisément compte des moyens employés ?

Raconter une histoire

décembre 8th, 2025Quel est le domaine dans lequel les aèdes grecs étaient passés maîtres ? Celui de raconter des histoires à des auditeurs attentifs et dont la moindre des actions était de les reprendre en cas de manquements. L’Iliade et l’Odyssée composées par un ou plusieurs poètes furent d’abord racontées en public avant que d’être couchées par écrit par un ou des scribes dont Homère aurait pu faire partie. Au début fut un récit dont la transmission orale autorisait quelques modifications mineures sur un thème constant. Les répétitions et les nombreux adjectifs accolés aux personnages permettaient qu’ils soient reconnus de tous et partout. Platon, le premier peut-être, s’opposa avec vigueur au passage de l’oralité à l’écriture arguant du fait que cette dernière affaiblirait voir entrainerait la disparition de la mémoire à plus ou moins long terme ! Aujourd’hui encore le débat n’est pas clos, puisque l’on continue de se pencher sur le rôle pour la mémoire, de ceux qui racontent des histoires (How the Art of Storytelling Alters Memory Formation). La problématique concernant les stratégies narratives et la mémorisation : perception vs conceptualisation. Ce qui est particulièrement intéressant c’est qu’à ces deux aspects correspondent deux voies de connectivité neuronale divergentes depuis l’hippocampe. Pour l’instant rien de plus que cette constatation neurophysiologique, mais que celui qui raconte n’oublie pas les détails tels que l’hippocampe puisse diriger correctement ses informations !

Essence vs existence, conscience vs matière

novembre 30th, 2025Les rapports qu’entretiennent l’essence et l’existence constituent (si cela peut être dit ainsi) le fond de commerce de celui qui a refusé le prix Nobel de Littérature en 1964. L’existence précède l’essence dans la mesure où en dehors de toute détermination, c’est par ses actes que l’homme tire son essence, ce qui l’oppose à Descartes pour lequel l’essence définissait l’existence, tandis que pour Heidegger, l’essence résidait dans l’existence. A l’évidence essence et existence ne peuvent que se heurter quand ils se rencontrent d’autant plus que l’un est concept et l’autre réalité. Mais là où le jeu se complique c’est lorsque l’on aborde le thème de la réalité, qui est matière. S’il est classique de voir la matière préexister à la conscience, il l’est beaucoup moins d’affirmer le contraire. Pourtant c’est l’hypothèse que fait Maria Strømme, professeure à l’Université d’Uppsala (https://pubs.aip.org/aip/adv/article/15/11/115319/3372193.) : « selon le modèle de Strømme, ce que nous appelons matière n’est pas la brique élémentaire de la réalité, mais plutôt une représentation, voire une illusion« . Il s’agit là d’une véritable révolution intellectuelle qui fait que le lecteur échange un vertige pour un tourbillon tel qu’il se heurte à des millénaires de certitude(s). On entre alors dans une autre science de la matière, telle que l’étudie Maria Strømme, qui fait reconsidérer la notion de réalité dans le même temps que ce que l’on considérait comme marges de la dite réalité, ainsi que bien des textes qui s’y apparentent (https://sciencepost.fr/une-physicienne-formule-mathematiquement-ce-queinstein-pressentait-la-conscience-precede-la-matiere/). En définitive, cette étude remet en question des idées reçues et invite à un changement de perspective : plutôt que de considérer la conscience comme un épiphénomène de la matière, elle la place au fondement même de l’existence. Quand le structuralisme proposait la formule canonique du mythe, quand la théorie du tout reste le graal, Maria Strømme « en synthétisant des apports de la physique, de la métaphysique et de la philosophie, […] propose une voie vers une compréhension intégrée qui unit la rigueur scientifique à la sagesse philosophique antique« . L’homme reste en demande d’un tout unifié et unificateur !